Interface編集部

12月号特集第1部第8章 視覚言語モデルVLMサポート・ページ

========================================

最新型はマルチモーダルAI「GPT-4V」 石垣 達也

========================================

OpenAIのGPT-4V(Vision)やGPT-4oは,VLMを実務レベルに引き上げ,現在最もよく使われているVLMです.

※2025年10月現在,利用には5ドル程度の課金が必要です.

●動作イメージ

大規模言語モデルを画像にも対応できるように改善したモデルです.このモデルに画像を入力すると,それを読み取って自然言語で答えたり提案したりできます.

●利用のためには課金とAPIキー取得が必要

コードの実行にはOpenAI APIキーが必要です.OpenAI Platform(https://platform.openai.com/chat)にアクセスしログイン後,左サイド・バーのAPIキーに進みます.

右上の「Create new secret key」をクリックし,右下の「Create secret key」を押すとAPIキーが発行されます.2025年の段階で,OpenAIは無課金ユーザへのAPI提供を停止しています.無課金ユーザは Billingページ(https://platform.openai.com/settings/organization/billing/overview)から5ドル程度をクレジットカードで支払いをするとAPIキーを入手できます.

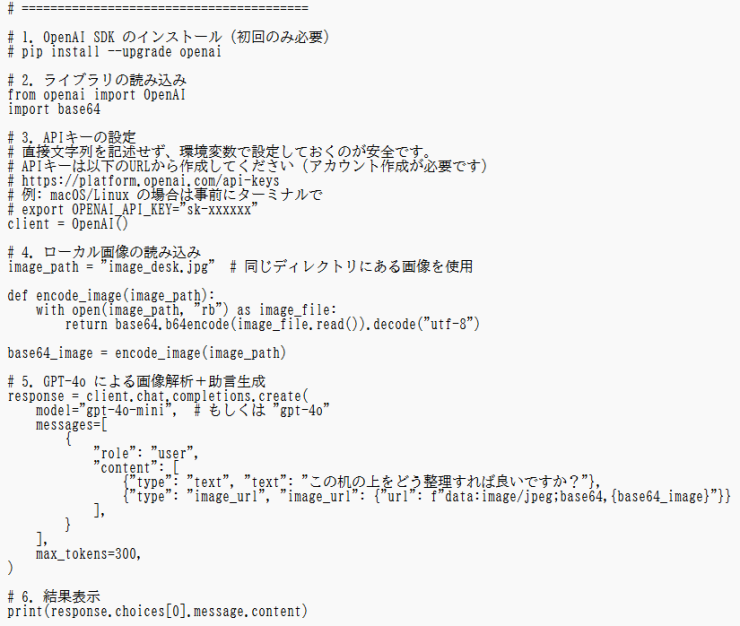

●実行

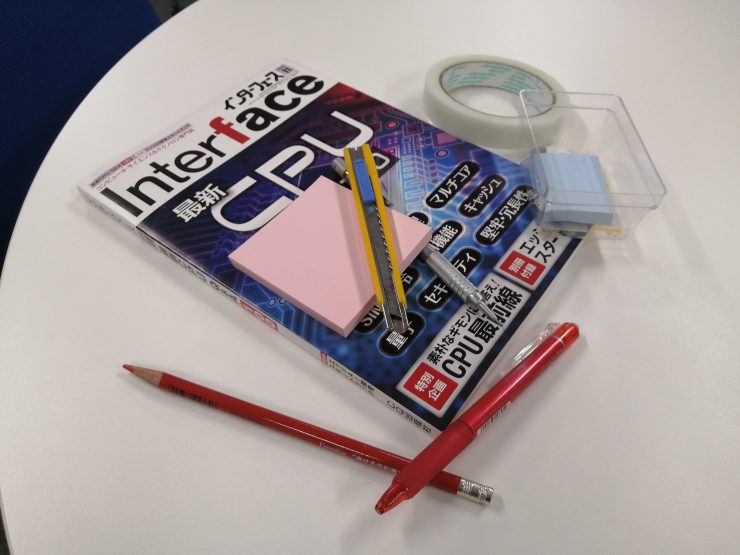

リストAにGoogle Colabで動作するサンプル・コード(GPT-4o利用を想定)を示します.これに写真Aの画像を入力すると,散らかった机の画像がアップロードされ,どのような手順で掃除をすべきか助言してくれます.特にGPT-4VのようなAPIベースにVLMは既存業務に組み込みやすく,社内システムと連携させることで多様な業務効率化が期待できます.例えば,次のような業務に活用できるでしょう.

・文書整理(スキャンした書類の自動仕分け)

・画像検索(数万枚の製品写真から該当品を探す)

・アクセシビリティ(視覚障害者向けに画像を言葉で説明)

リストA コードはコチラからダウンロード可能

写真A

*

今回,12月号記事で,CLIPによる分類から始まり,BLIPによる理解と生成の両立,FlamingoのFew-shot学習を,そして,本特設コーナで,GPT-4Vの実用化へと進化したGPT-4oまでと,VLMの技術発展の流れにそって解説しました.

その流れは今や動画や音声にも広がり,私たちの働き方そのものを変えようとしています.数行のコードで「画像を理解し,助言してくれるAI」を業務に組み込める時代がきつつあります.視覚言語モデルは単なる技術的なツールではなく,ビジネスの現場を変革する新しいパートナになり得るものです.これからの職場において,視覚言語モデルは欠かせない存在となるでしょう.

いしがき・たつや

——

・禁無断転載.収録したプログラム,データおよびドキュメントなどの著作権は,各著作権者(すなわち筆者)にあります.

Copyright (C) 2025 Tatsuya Ishigaki

・免責事項

(1)プログラムやデータの使用により,使用者に損失が生じたとしても,著作権者とCQ出版(株)は,その責任を負いません.

(2)プログラムやデータにバグや欠陥があったとしても,著作権者とCQ出版(株)は,修正や改良の義務を負いません.